Введение

Автоматизированные инструменты тестирования, включая Selenium, демонстрируют высокую эффективность, но их надежность остается уязвимой. Даже минимальные изменения в структуре DOM способны нарушить работу локаторов, а асинхронное выполнение приводит к непредсказуемым результатам. Появление flaky-тестов снижает доверие разработчиков и вынуждает тратить значительные ресурсы на отладку. Дополнительные сложности создают зависимые сервисы и инфраструктурные компоненты, от которых напрямую зависит успешность прогонов. Современные практики веб-тестирования тесно связаны с распределенными окружениями и системами непрерывной интеграции. Это усложняет процесс и увеличивает вероятность сбоев: сетевые задержки, несогласованность драйверов и ошибки синхронизации могут проявляться в виде ложных отказов. В условиях распределенных систем автоматизация сталкивается с рядом типичных уязвимостей – нестабильные сценарии, обусловленные асинхронностью, и хрупкие локаторы интерфейсов, требующие регулярной поддержки. Все это снижает воспроизводимость и подрывает устойчивость тестовых процессов.

Цель исследования – проанализировать и классифицировать современные методы повышения надежности автоматизированного тестирования веб-приложений, с учетом инструментальной базы Java и Selenium, интеграции с CI/CD-контурами, а также применения технологий машинного обучения и интеллектуальных систем для адаптивного сопровождения тестов.

Материалы и методы исследования

Работа выполнена в формате систематизированного обзора, что позволило охватить современные подходы к повышению надежности автоматизированного тестирования веб-приложений и сопоставить их по критериям применимости в проектах на базе Java, Selenium и CI/CD-инфраструктур. Для поиска источников использовались ключевые слова на русском и английском языках: «flaky-тесты», «устойчивость автотестов», «Selenium reliability», «CI/CD test automation», «Java testing frameworks», «test flakiness mitigation». Подбор литературы проводился в международных и отечественных библиографических базах (ACM Digital Library, IEEE Xplore, SpringerLink, Scopus, eLibrary, CyberLeninka). Временные рамки ограничены периодом с 2016 по 2025 г., что обеспечивает учет как фундаментальных работ последних лет, так и новейших решений, связанных с внедрением ML-подходов и облачных инструментов. В обзор были включены 25 публикаций из 106, содержащие эмпирические данные или предложенные методики, связанные с устойчивостью автоматизированного тестирования пользовательских интерфейсов. Рассматривались статьи, посвященные управлению драйверами, выбору стратегий локаторов, использованию распределенных сред, контейнеризации и интеграции с CI/CD-системами. Исключались материалы, описывающие только модульное тестирование без связки с UI-слоем, работы без экспериментальной базы, а также обзоры без конкретных практических предложений.

Результаты исследования и их обсуждение

Практика, согласно исследованию Б. Гарсия и соавт., показывает: во многих командах драйверами Selenium WebDriver по-прежнему управляют вручную – скачивают, настраивают, поддерживают. Такая рутина повышает входной порог и добавляет точки отказа: несовпадение версий браузера и драйвера приводит к ложным падениям, а обновляющиеся «вечнозеленые» браузеры (Chrome, Firefox, Edge, Opera) регулярно ломают сборки сообщением вроде «данная версия chromedriver поддерживает только Chrome N». Устойчивость набора UI-тестов в этих условиях страдает, а стоимость сопровождения растет. Снять часть рисков помогают проверенные практики на уровне кода: корректная работа с ожиданиями и локаторами, а также применение шаблона Page Object Model, уменьшающего связанность и издержки на поддержку. В инфраструктуре Java-проекта дополнительные дивиденды дает автоматизированное управление драйверами (WebDriverManager) и интеграционные расширения для JUnit 5 (например, Selenium-Jupiter), которые убирают значительную долю ручной конфигурации [1].

Фиксированные паузы Thread.sleep выглядят простым решением, но на длинных прогонах они раздувают время выполнения и сами по себе вносят недетерминизм. Гораздо надежнее явные ожидания: условие выполнено – ожидание завершено; нет причины ждать – нет лишних секунд. Такой подход позволяет синхронизироваться с динамическим контентом, проверять сложные предикаты и заметно снижать долю «флейки»-падений. В зрелых кодовых базах логично проводить «санитизацию» тестов: целенаправленно убирать sleep и заменять их на explicit waits, добиваясь сокращения общего времени пайплайна без появления новых источников нестабильности [2].

Локаторы – один из самых хрупких элементов веб-автотестов: любая правка верстки или атрибутов легко выводит из строя сценарий. Наиболее живучими считаются идентификаторы id – они обычно уникальны и меняются редко, однако доступны не всегда. XPath универсален, но абсолютные пути ломаются чаще относительных. Согласно исследованию D. Clerissi, M. Leotta и F. Ricca повысить качество набора помогает системная профилактика: ревизии локаторов, переход на более устойчивые стратегии, а также «игровые» механики, стимулирующие разработчиков тестов (например, регулярные задания по замене абсолютных XPath на относительные с накоплением «очков» и ачивок) [3]. Такая мотивация делает практики робастности регулярной привычкой, а не разовой кампанией.

Selenium остается базовым выбором для кросс-браузерной автоматизации благодаря открытой экосистеме и множеству интеграций [4]. Вместе с тем отдельные задачи эффективнее решают специализированные инструменты: Applitools применяет системы автоматизированного визуального распознавания для визуальных расхождений [5]; Sahi упрощает старт за счет встроенной среды, но уступает в гибкости крупным фреймворкам. В мире Java широкое распространение получил Selenide: он снимает слой шаблонного кода, предлагает встроенные «умные» ожидания и тем самым облегчает сопровождение и снижает вероятность ошибок синхронизации [6; 7].

Анализ методов уровня тест-дизайна демонстрирует, что устойчивость и предсказуемость UI-тестов зависят не только от применяемых инструментов, но и от системного пересмотра практик их построения. Автоматизация управления драйверами, переход от фиксированных пауз к явным ожиданиям и осознанная работа с локаторами позволяют снизить вероятность «флейки»-падений и сделать пайплайн менее ресурсоемким. Совмещение этих приемов с более зрелыми библиотеками и интеграционными расширениями формирует основу для снижения стоимости сопровождения и повышения доверия к результатам автоматизированного тестирования.

Распределенный запуск на Selenium Grid позволяет раскидать тесты по нескольким машинам и конфигурациям. Архитектура hub-and-node дает нужную масштабируемость, сокращает время обратной связи и повышает надежность за счет проверки в разных средах. Такой режим органично встраивается в Agile-процессы: дефекты всплывают раньше, а непрерывное тестирование перестает быть узким местом доставки [8].

Контейнеры привносят воспроизводимость и изоляцию, платформы уровня ElasTest используют Docker для сборки и развертывания SUT, подключают инструментирование и рекомендательные механизмы на ML, что помогает бороться со сквозной нестабильностью. Гибкость достигается как готовыми образами из Docker Hub, так и оркестрацией многоконтейнерных систем через Docker Compose [9]. На стороне CI/CD все больше внимания уделяется автоматической генерации пайплайнов: это снижает ручной труд, сокращает ошибки конфигурации и ускоряет выпуск – в эксперименте Н.И. Дьяченко и А.В. Забродина полный цикл от коммита до новой версии занял 5 мин 37 с без перерыва в работе сервиса [10].

Согласно исследованию B. García и соавт. E2E-сценарии падают «черным ящиком», и без клиентских артефактов первопричину не видно. Систематический сбор консольных логов и трассировок из автоматизированных браузеров закрывает этот пробел. Поскольку ручной сбор дорогостоящий и уязвимый к ошибкам, полезны расширения класса BrowserWatcher, которые добавляют наблюдаемость «на грани браузера». Предупреждения в консоли – хороший предиктор будущих проблем, их профилактическая очистка снижает риск повторяющихся падений [11].

Эффективность инфраструктурных решений для автоматизированного тестирования проявляется в их способности совмещать масштабируемость и воспроизводимость с глубокой наблюдаемостью. Контейнеризация и оркестрация не только сокращают время обратной связи, но и формируют устойчивый контур, где непредсказуемость среды минимизируется. Встраивание инструментов логирования и мониторинга в связке с CI/CD позволяет превратить тестовый процесс из набора разрозненных процедур в целостный механизм, поддерживающий надежность веб-приложений на всех стадиях жизненного цикла.

GitLab CI/CD, Jenkins и сходные системы позволяют формировать цепочки этапов, где порядок тестов отражает логику контроля качества. Запуски происходят автоматически при каждом изменении, неуспешные результаты блокируют слияние и возвращают обратную связь разработчику. Для UI-сценариев критичны скорость и детерминизм [12]. Масштабирование достигается параллельными прогонами на распределенном парке агентов вместе с Selenium Grid. При этом необходимо добиваться независимости тестов и управлять нестабильными кейсами – ограничивать время шага, применять высокоуровневые библиотеки поверх WebDriver, настраивать ожидания, использовать карантин для проблемных тестов до их исправления [13].

Шаблонизация и синтез пайплайн из метаданных проекта стандартизируют процесс, снимают рутину и уменьшают вероятность человеческих ошибок. Этапы сборки, тестирования и деплоя подбираются под специфику репозитория, что упрощает поддержку и делает поведение конвейера предсказуемым. Испытания показывают, что такой подход реально снижает трудозатраты и стабилизирует выпуск [10].

По мнению J. Bell и соавт. повторные прогоны для выявления «флейки» дороги и тормозят цикл. Альтернатива – анализ покрытия последних изменений: если упавший тест не исполнял измененные строки, падение с высокой вероятностью flaky [14]. Инструменты класса DeFlaker реализуют эту идею и позволяют отмечать нестабильные тесты без каскада перезапусков. R. Khankhoje отмечает, что параллельно применяются стратегические меры: изоляция нестабильных кейсов, приоритизация исправления первопричин, а не «перезапуск как лекарство» [15].

Эффективность CI/CD-практик во многом определяется тем, насколько инженерные команды умеют сочетать автоматизацию рутинных действий с активным управлением нестабильными сценариями. Совмещение шаблонного синтеза пайплайнов, аналитических инструментов для выявления «флейки» и стратегической изоляции проблемных тестов превращает тестовую инфраструктуру в адаптивную систему, способную поддерживать баланс между скоростью поставки и качеством продукта. Такая организация процессов снижает издержки на сопровождение и укрепляет доверие к результатам автоматизированного контроля качества.

Чтобы уменьшить ложные срабатывания, из сравнения исключают «шум» – всплывающие уведомления, анимации и прочие волатильные элементы. Маскирование и фильтры позволяют концентрироваться на значимых отклонениях макета и контента. Технологический стек часто включает Selenium для взаимодействия с UI, библиотеки обработки изображений (например, PIL) и параллелизацию на уровне тестового раннера (Pytest-xdist). Параллельные прогоны по наборам устройств/браузеров дают приемлемое время обратной связи. Линия развития – приближение к «человеческому» восприятию интерфейса: использование компьютерного зрения для семантического сравнения экранов [16]. Коммерческие решения вроде Applitools и Functionize применяют ИИ для устойчивого визуального сравнения и даже «самовосстановления» сценариев при несущественных изменениях UI, что снижает издержки поддержки [5].

Визуальное тестирование постепенно выходит за рамки «механического» сравнения скриншотов и превращается в интеллектуальный инструмент оценки интерфейсов. Совмещение методов фильтрации шумовых артефактов с компьютерным зрением и ИИ-платформами формирует новый уровень надежности: система способна различать критические расхождения и игнорировать незначительные визуальные изменения без участия человека. В результате снижается не только число ложных срабатываний, но и издержки сопровождения, а тестовые сценарии начинают отражать восприятие интерфейса конечным пользователем, а не только формальные расхождения пикселей.

Крупные языковые модели (GPT-4, Codex, CodeT5) уже умеют анализировать код и синтезировать осмысленные тестовые случаи, демонстрируя высокие показатели покрытия и точности. При этом сохраняется необходимость экспертной валидации: «галлюцинации» и нерелевантные проверки пока не редкость, а стоимость ложных тревог в CI/CD велика [17]. Как отмечают D.P. Nguyen и S. Maag, частая причина падений – эволюция DOM и атрибутов. Self-healing-подходы пытаются адаптироваться автоматически: модели распознают целевой элемент по набору признаков и перенастраивают шаги взаимодействия. «Бескодовое» тестирование с ML-надстройкой снижает объем ручного рефакторинга при изменениях интерфейса [18]. Интеграция машинного обучения включает сбор датасетов, извлечение признаков, обучение, онлайн-инференс, генерацию тестов и цикл обратной связи. В ряде экспериментов такие пайплайны показывают прирост надежности и эффективности по сравнению с чисто скриптовыми решениями [19].

Применение ML/AI в автоматизации тестирования демонстрирует переход от реактивной поддержки сценариев к проактивному самовосстановлению, где система не только фиксирует поломку, но и предлагает корректировку на основе накопленных закономерностей. Такой сдвиг открывает возможность рассматривать тестовую инфраструктуру как адаптивную экосистему, в которой алгоритмы снижают стоимость ручного рефакторинга и повышают устойчивость пайплайна к изменениям интерфейса, сохраняя при этом контроль за качеством за счет экспертной верификации.

Переиспользование библиотек ускоряет разработку, но одновременно приносит уязвимости. Команды нередко затягивают обновления из-за боязни регрессий и накладных расходов на обслуживание зависимостей. Исследования отмечают: более половины security-апдейтов, созданных ботами, доходят до слияния. Наличие тестов и CI повышает готовность принимать такие PR – снижается риск нарушить обратную совместимость незамеченным дефектом. По мнению H. Mohayeji и соавт., Dependabot централизует обнаружение и обновление уязвимых пакетов через автоматические pull-requests. Для больших портфелей репозиториев это становится действенным механизмом поддержания базовой гигиены цепочки поставок [20].

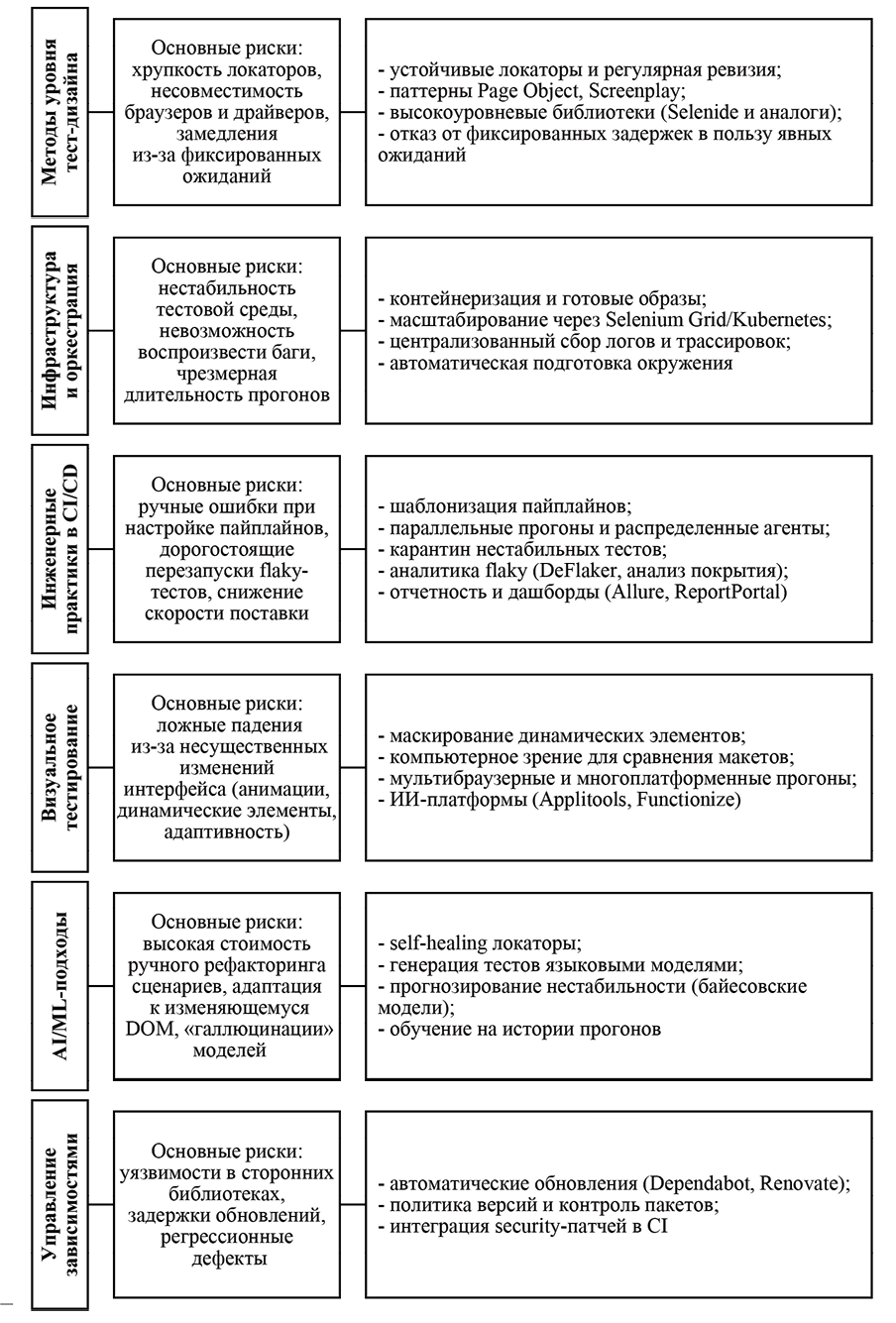

Классификация методов повышения надежности автотестов Источник: составлено автором

Чек-лист по слоям автоматизированного тестирования

|

Слой |

Проблемы |

Метод решения |

|

Код (тест-дизайн) |

– несовместимость версий браузеров и драйверов при ручном управлении; – задержки и нестабильность из-за Thread.sleep; – хрупкость локаторов (особенно абсолютных XPath) |

– автоматизация управления драйверами; – замена фиксированных пауз на явные ожидания; – применение Page Object Model для снижения связности; – переход на устойчивые стратегии локаторов (id, относительные XPath), регулярные ревизии; – использование высокоуровневых библиотек |

|

Инфраструктура |

– длительные прогоны без параллелизации; – нестабильность среды и трудности воспроизведения; – недостаточная наблюдаемость (отсутствие логов и артефактов) |

– запуск на распределенных узлах (Selenium Grid); – контейнеризация и оркестрация (Docker, Docker Compose); – интеграция логирования и мониторинга; – автоматическая очистка и поддержка тестовых данных |

|

CI/CD |

– ошибки ручной настройки пайплайнов; – зависимость скорости поставки от нестабильных кейсов; – высокая стоимость повторных прогонов для поиска flaky-тестов |

– автоматическая генерация и шаблонизация пайплайнов; – масштабирование за счет параллельных запусков; – управление flaky-тестами (карантин, ограничение времени шага); – анализ покрытия для выявления нестабильных тестов |

|

ML/AI |

– высокая стоимость ручного рефакторинга при изменениях DOM; – ложные тревоги и «галлюцинации» моделей; – медленная адаптация сценариев к меняющемуся UI |

– использование self-healing локаторов; – генерация тестов на основе ML-моделей; – сбор датасетов и обучение моделей на истории запусков; – экспертная валидация результатов |

Источник: составлено автором на основе полученных данных в ходе исследования.

Современные практики работы с зависимостями показывают, что автоматизация обновлений превращается из вспомогательного инструмента в критический элемент безопасности: централизованные механизмы наподобие Dependabot минимизируют человеческий фактор и систематизируют устранение уязвимостей. Эффективность этих решений напрямую зависит от зрелости CI/CD-контура и качества тестового покрытия, позволяя командам одновременно снижать риск регрессий и поддерживать устойчивость цепочки поставок на уровне, недостижимом при ручной поддержке. На рисунке систематизированы методы повышения надежности автоматизированного тестирования.

Масштаб проблемы подтверждается индустриальными цифрами: доля «флейки» в крупных компаниях измеряется процентами от миллионов прогонов. Снижение ложноположительных/ложноотрицательных срабатываний и изоляция тестов от внешних зависимостей заметно укрепляют доверие к конвейеру [21; 22]. Для прогнозирования нестабильности применяются байесовские модели, вплоть до сетей, дающих существенный выигрыш в стабильности CI [21]. В более общем виде используются байесовские схемы с учетом априорной информации (в том числе с регрессионным ее взвешиванием), а также методы статистического контроля процессов: карты Шухарта для независимых показателей и статистика Хотеллинга для многомерных зависимых метрик [23; 24].

Как отмечают A. Ahmad, O. Leifler и K. Sandahl, оперативные дашборды и хранилища артефактов (логи, скриншоты, видео) ускоряют поиск причины падений и упрощают выявление «флейки» [21]. Визуализация тенденций по ключевым показателям помогает целенаправленно снижать технический долг набора тестов. Комплексные стратегии тестирования – от модульных до нагрузочных – при встроенности в конвейер повышают качество и уменьшают вероятность попадания дефектов в продакшн, что подтверждается прикладными исследованиями [22].

Анализ метрик показывает, что надежность автотестов перестает быть субъективной оценкой и превращается в количественно измеряемый показатель, где статистические модели и процессный контроль задают объективные границы стабильности CI. Интеграция байесовских прогнозов с оперативной визуализацией и артефактами позволяет не только быстрее локализовать «флейки», но и формировать стратегии снижения операционных издержек разработки.

Для масштабируемых наборов на Java + Cucumber + Selenium важны принципы модульности: независимые сценарии, Page Object, параметризация, регулярная актуализация, контроль версий и обязательная отчетность. В Java-экосистеме Selenide упрощает чтение и поддержку сценариев за счет декларативных API и «умных» ожиданий. Cucumber настраивается на автозапуск по каждому изменению кода; Selenide без труда «срастается» с JUnit/TestNG и типовыми конвейерами (Jenkins, GitLab CI/CD, Travis). Это делает включение UI-контролей в поток поставки рутинной процедурой, а не спецоперацией [25; 7].

Стабильность достигается не только кодом, но и гигиеной окружения: регулярная очистка зомби-процессов на узлах Grid, автоматическое управление драйверами, подготовка тестовых данных. Для ускорения – параллельные прогоны и распределенные агенты, но при условии независимости тестов [13]. Cucumber Reports, Allure, ReportPortal, Grafana и другие инструменты обеспечивают прозрачность: от результатов конкретного запуска до динамики ключевых метрик [25; 13]. Это поддерживает дисциплину качества и ускоряет обратную связь. Переход на Selenide имеет смысл оформлять как последовательный план: подготовка среды, перенос и рефакторинг сценариев, настройка ожиданий, интеграция с CI/CD [7, c. 65]. Итог – более стабильный, читаемый и удобный для сопровождения набор UI-тестов. В таблице отображены ключевые проблемы в автоматизированном тестировании и методы их решения.

Систематизация методик разработки и опора на проверенные библиотеки позволяют превратить автоматическое тестирование в управляемый и воспроизводимый процесс, а не в набор разрозненных практик. Четкая организация сценариев в связке с Cucumber и Selenide, дополненная инструментами мониторинга и отчетности, формирует прозрачный цикл обратной связи и закрепляет дисциплину качества. В результате тестовый контур становится не только технически устойчивым, но и управленчески предсказуемым, что напрямую снижает риск сбоев в поставке продукта.

Заключение

В условиях CI/CD разработчики вынуждены балансировать между скоростью получения обратной связи и стабильностью прогонов. Повторное выполнение тестов помогает фильтровать нестабильные результаты, но замедляет выпуск продукта, тогда как их пропуск чреват пропуском критических ошибок. Этот компромисс остается одной из ключевых проблем. Практика показывает, что параллельное выполнение сценариев ускоряет процесс, но одновременно повышает риск возникновения состояний гонки и flaky-поведения. Даже успешно прошедшие тесты в одном окружении не гарантируют корректности в другом: различия в версиях библиотек, браузеров и конфигурациях приводят к ложным отказам и ставят под сомнение достоверность полученных данных. Анализ показывает, что дальнейшее развитие методов должно быть сосредоточено на повышении устойчивости тестов и сокращении числа flaky-сбоев. Требуется больше исследований в области автоматической адаптации локаторов и интеграции тестовых решений с облачными CI/CD-средами. Эти направления формируют перспективные задачи для будущих исследований.